GENIAC第3期で自律稼働デバイス向けの軽量な大規模視覚言語モデルPLaMo 2.1-8B-VLを開発

工場内作業タスク分析やドローンによる異常検知等のユースケース検証のモニター企業を募集

株式会社Preferred Networks(本社:東京都千代田区、代表取締役社長:岡野原大輔、以下、PFN)は、経済産業省およびNEDOによるGENIAC*1第3期において開発を進めている自律稼働デバイス向けの軽量かつ高精度な大規模視覚言語モデル(Vision Language Model、VLM)PLaMo 2.1-8B-VLについて、同モデルを活用した技術検証のモニター企業募集を開始します。本取り組みでは、2026年3月末まで無償でPLaMo 2.1-8B-VLを利用可能とし、様々な環境でのユースケース検証を通じて、VLMの機能向上、および、アプリケーション開発に還元していきます。

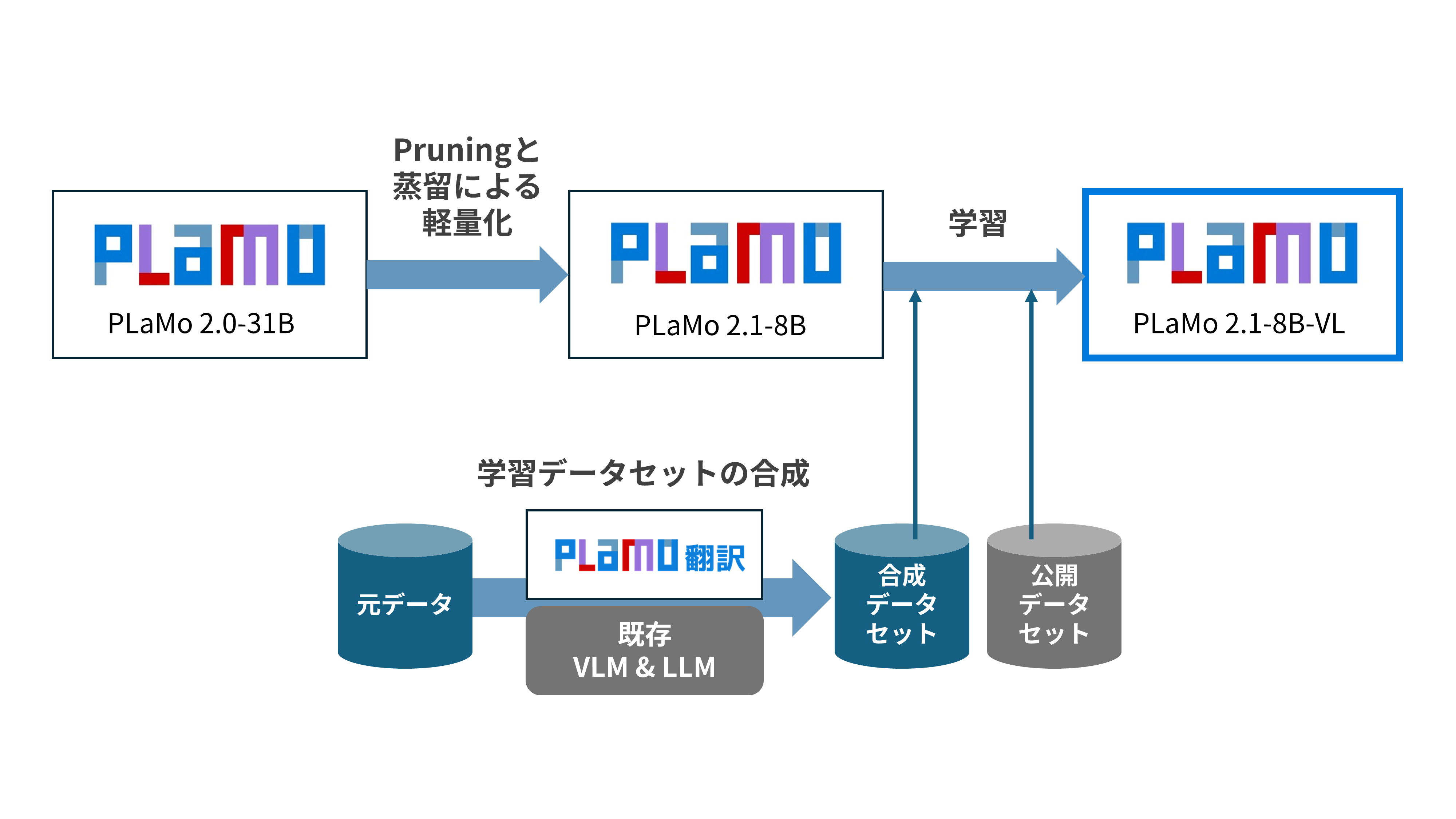

PFNは、ドローン、ロボット、自動車、監視カメラなどの自律稼働デバイスや、オンプレミス環境など、クラウド接続が難しい現場での利用を想定した、軽量かつ高精度なVLMとしてPLaMo 2.1-8B-VLを開発しています。PLaMo 2.1-8B-VLは、大規模言語モデルPLaMo 2.0-31BをPruningおよび蒸留*2によって軽量化したPLaMo 2.1-8Bをベースモデルとして使用し、視覚情報と言語情報を統合して処理することで、産業領域での実用的なフィジカルAIに必要となる高度な画像理解タスクに対応することを目指しています。

同モデルは、画像に関する日本語テキストに対して自然な応答を返す能力を評価するVQA(Visual Question Answering)ベンチマークJA-VG-VQA-500およびテキストの指示が指す人物や物体を画像中から正しく特定する能力を評価するVisual GroundingベンチマークRef-L4において、Asagi-14BやQwen3-VL-8Bを上回る評価スコアを達成し、同等サイズのモデルとの比較で世界最高水準の性能を示しています。これらのベンチマークで評価される、位置関係の把握、行動の理解、属性認識、複合的な説明文の理解といった基本性能は、作業分析、異常検知、設備点検など、高度な判断が求められる実際の産業現場でAIを活用するために不可欠な要素です。

VQAの例

質問:前方に積まれているのは何ですか?

PLaMo 2.1-8B-VLの回答:スイカ

示す能力:「前方」という相対的な位置表現を手がかりに、該当する領域にある物体(スイカ)を特定する能力

(位置関係に基づく物体認識)

写真:Pixabay「Fruit Mart」

出典:Stockvault

URL:https://www.stockvault.net/photo/200223/adler32

ライセンス:Creative Commons - CC0

※本記事での掲載にあたり画像の加工は行っていません

質問:自転車に乗っている人の中で一番小さい人のヘルメットの色は何色ですか?

PLaMo 2.1-8B-VLの回答:青色

示す能力:自転車に乗る複数の人物から「一番小さい人」を相対的に見分け、その属性(ヘルメットの色)を答える能力

(比較・関係推論+属性認識)

写真:Kamyar Adl「Family Ride bicycle cycle trailer」

出典:Wikimedia Commons(元画像は Flickr 掲載)

URL:https://commons.wikimedia.org/wiki/File:Family_Ride_bicycle_cycle_trailer.jpg

ライセンス:Creative Commons Attribution 2.0 Generic (CC BY 2.0, https://creativecommons.org/licenses/by/2.0/)

※本記事での掲載にあたり画像の加工は行っていません

Visual Groundingの例

指示文:他の犬と人間を見ている犬のバウンディングボックス座標を出力してください。

示す能力:視線方向や周囲の物体との位置関係など、複数の手がかりを統合して対象となる犬を特定する能力。

(位置関係理解)

写真:lasta29「Search and rescue dog, Japan Rescue Association」

出典:Wikimedia Commons

URL:https://commons.wikimedia.org/wiki/File:Search_and_rescue_dog,_Japan_Rescue_Association_(34690315563).jpg

ライセンス:Creative Commons Attribution 2.0 Generic (CC BY 2.0, https://creativecommons.org/licenses/by/2.0/)

※本記事に掲載するにあたりバウンディングボックス(緑枠)を追加しています

.png)

指示文:ショベルカーの近くにあるクレーンを検出して。

示す能力:複数のクレーンの中から「ショベルカーの近く」という空間的関係表現を手がかりに対象を特定し、その領域を出力する能力

(関係表現の理解+空間推論)

写真:Pixabay(経由:PICRYL)

URL:https://picryl.com/media/highway-construction-site-valley-bridge-crash-dc08bd

ライセンス:CC0 1.0 Universal (Public Domain Dedication)

※本記事に掲載するにあたりバウンディングボックス(緑枠)を追加しています

PLaMo 2.1-8B-VLの開発および性能評価の詳細はブログをご覧ください:

https://tech.preferred.jp/ja/blog/plamo21_8b_vl/

主な想定ユースケース

PLaMo 2.1-8B-VLは、特にクラウドを介さずエッジ側で処理するニーズが高い領域での利用を想定し、GENIAC第3期の中で、基本性能(VQAとVisual Grounding)の向上、および下記のような主要タスク向けのアプリケーションの開発を進めています。

工場内の作業タスク分析

- 作業工程に漏れや異常がないかを検出

- 作業者の動作を画像から把握し、安全性や品質向上に活用

ドローンによる建物・構造物の異常検知

- 建物や構造物の外観から、ドア開放・落下物・異常物体を自動で検出

カメラによる監視・保全・セキュリティ用途

- 工場・倉庫・店舗・重要施設でのリアルタイム監視

- 機密情報のクラウド送信が困難な現場の監視

モニター企業募集概要

今回、PLaMo 2.1-8B-VLを2026年3月末まで無償提供し、上記の想定ユースケースをはじめとする、企業が抱える現場課題に対して技術検証を行います。今回の技術検証で得られた結果をもとに、VLMの基本性能の向上、およびユースケースに応じたアプリケーション開発を進めていく予定です。

提供内容・条件

- PLaMo 2.1-8B-VLをクラウドAPI経由で無償提供(2026年3月末まで)

- お申込み後、約1か月程度で利用開始

- 利用期間中のクラウド費用はPFNが負担

- モデル改善のため、利用期間中の画像データはPFN側でも閲覧可能(オプトアウトのご相談も可能)

募集目的

- 実際の現場データを用いた技術検証

- ユースケースの具体化

- 社会実装に向けたフィードバックの取得

申込方法

- こちらのフォームからお問合せください https://forms.gle/x5JUAeRU9iwX3Cmq9

PFNは、PLaMo 2.1-8B-VLを活用した産業現場での検証を通じて、軽量かつ高精度な自律稼働デバイス向けVLMの機能を強化し、2026年春の提供に向けて、実際の現場で活用できるモデルの開発を進めていきます。

PLaMoについて https://plamo.preferredai.jp/

PLaMo(プラモ)は、PFNがフルスクラッチで開発する国産大規模言語モデルです。商用版のフラッグシップモデルPLaMo Prime、自動車や製造設備などのエッジデバイス向けに軽量化された小規模言語モデルPLaMo Lite、日本の金融知識を追加学習した金融特化型PLaMo、日本語の翻訳に特化したPLaMo翻訳など、用途に合わせて提供しています。PLaMo Primeはクラウド型API、Amazon Bedrock Marketplace、オンプレミスなどの提供形態があり、国産AI構築プラットフォームmiibo、法人向け生成AIサービスTachyon 生成AI、150以上の自治体が導入するQommonsAIなどのサービスに標準搭載されています。

*1:GENIAC(Generative AI Accelerator Challenge):2024年から経済産業省およびNEDO(国立研究開発法人新エネルギー・産業技術総合開発機構)が実施する、日本の生成AI開発力向上を目指すプロジェクト。PFNは第1期、第2期、第3期に採択され、これまでに開発したモデルの一部は、学術・研究用途の非商用ライセンスモデルPLaMo-100B-Pretrainedなどのオープンモデルとして公開しています。

*2:Pruningと蒸留:いずれも大規模なモデルを軽量化する手法。Pruningは、不要と評価されたパラメータを削除するなどして軽量化します。蒸留は、大きなモデルの入力に対する出力を真似するように別モデルを学習させ、小さいモデルにします。